Quick, aber nicht dirty – Klassische und neue Ansätze bei der Usability-Evaluation von Websites durch Experten

1. Die Idee

Es gibt eine Reihe von Ansätzen, bei denen die Applikation bzw. in unserem Fall das Web-Angebot nicht mit Personen der Zielgruppe getestet wird, sondern von Experten. Bei diesen sogenannten „Usability Inspection Methoden“ wird das Web-Angebot durch Experten – abhängig vom jeweiligen Ansatz – in einer bestimmten Vorgehensweise inspiziert und beurteilt. Im Vergleich zu einem Test mit der Zielgruppe (Nutzer-Testing) ist diese Vorgehensweise mit einem geringeren zeitlichen und ökonomischen Aufwand verbunden. Häufig sind aufgrund der kürzeren Design-Zyklen (häufiger Relaunch) und der enormen Entwicklungsgeschwindigkeit von Webtechnologien die zeitlichen Restriktionen bei Web-Projekten sehr hoch. Aus diesem Grund ist die expertenbasierte Usability-Evaluation für die Website- und Online-Shop-Entwicklung von besonders hohem Interesse.

2. Klassische Ansätze der expertenbasierten Usability-Evaluation

Zu den wichtigsten klassischen Ansätzen gehören der Ansatz des Cognitive Walkthrough und die Heuristische Evaluation.

Cognitive Walkthrough (CW)

Bei dieser Methode inspiziert der Experte den durch das Webangebot vorgegebenen „optimalen“ Pfad zur Problemlösung (z.B. die Durchführung einer Bestellung). Dabei fragt sich der Experte, ob ein hypothetischer Nutzer diesen Pfad tatsächlich gegangen wäre. Der Best Match zwischen mentalen Fähigkeiten und den Anforderungen, die das Web-Interface an den Nutzer stellt, stehen im Vordergrund.

Heuristische Evaluation

Eine heuristische Evaluation dient dazu, Usability-Probleme einer Website auf der Basis grundlegender Prinzipien (sog. Heuristiken), zu erkennen und zu beschreiben. Der Experte inspiziert das Web-Angebot und vergleicht, in welchem Maße die Prinzipien angewendet wurden. Die Heuristiken beschreiben die grundlegenden Eigenschaften, die eine Anwendung besitzen sollte, damit der Nutzer in einem bestimmten Kontext die Anwendung effektiv, effizient und zufriedenstellend nutzen kann (vgl. Tabelle 1). Abweichungen und Inkongruenzen mit den Regeln werden als Usability-Probleme definiert. Der Evaluator erstellt eine Liste von Problemen, die er in Bezug auf die Anwendung sieht und vergleicht sie anschließend mit den Ergebnissen anderer Evaluatoren. Zum Schluß wird eine Gesamtliste mit Usability-Problemen erstellt und eingestuft, wie schwerwiegend die einzelnen Usability-Probleme sind.

| Heuristische Regeln nach NIELSEN (1994), sowie in ursprünglicher Version nach NIELSEN & MOLICH (1990) |

|---|

Heuristische Evaluation – Ein etabliertes Verfahren

Die heuristische Evaluation, die wir im weiteren näher diskutieren, hat sich in der Usability-Praxis z.B. der Software-Ergonomie etabliert und ist eine der meist genutzen expertenbasierten Verfahren. Sie ist aufgrund ihres geringen Formalisierungsgrads flexibel für jede Art von informations- und transaktionsorienten Websites einsetzbar. Gleichzeitig werden laut NIELSEN (1993 S.156) bereits durch wenige Evaluatoren (drei bis fünf) bis zu 75% der existierenden Usability-Probleme aufgedeckt.

„Wie reliabel und valide sind die Ergebnisse der heuristischen Evaluation im Vergleich zu den Nutzer-Testings?“

Ein mit dieser Frage einhergehender Aspekt ist, in welchem Verhältnis die inspizierenden Techniken zu den Nutzer-Testings stehen. Können sie Test mit Endnutzern ergänzen oder ersetzen oder sind ihre Ergebnisse einfach schlechter, respektive besser? In verschiedenen Methodentests (z.B. JEFFRIES et al. 1991, KARAT, CAMPBELL & FIEGEL 1992) wurde dieser Fragestellung nachgegangen. Zusammenfassend kann man sagen: das Verhältnis diese beiden Methoden ist komplementär. In der Studie von KARAT, CAMPBELL & FIEGEL zeigte sich beispielsweise, daß lediglich ein Drittel der Usability-Fehler von den untersuchten Erhebungsmethoden gleichermaßen gefunden wurden. D.h. Nutzertestings vs. expertenbasierte Methoden „filtern“ unterschiedliche Klassen von Usability-Problemen. Die Ergebnisse von KARAT, CAMPBELL & FIEGEL sprechen auch dafür, daß die heuristische Evaluation den Test mit End-Nutzern nicht ersetzen kann. So konnten im Nutzer-Testing nicht nur die größte Anzahl an konkreten Usability-Problemen identifiziert werden. Eine beträchtliche Menge an schweren Usability-Fehler wurde nur durch den Test mit Nutzern aufgedeckt. Nutzer-Testings erwiesen sich als überlegen bei der Identifizierung von „unique usability problem areas“, also Problem-Bereichen, die alleinig durch eine Methode entdeckt wurden.

Zwischenfazit: Wenn die entsprechenden zeitlichen und finanziellen Spielräume gegeben sind, dann sollte ein nutzerbasiertes Usability-Testing (optimalerweise in Kombination mit einer vorgeschalteten Expertenevaluation) durchgeführt werden.

„Die Expertise der Evaluatoren ist wichtig“

Es hat sich in vielen methodenvergleichenden Studien gezeigt (vgl. z.B. NIELSEN 1992, DESURVIVRE 1994, KARAT, CAMPBELL & FIEGEL 1992), daß für die Güte der Ergebnisse die Expertise der Evaluatoren von hoher Bedeutung ist. Idealerweise handelt es sich um Doppelexperten, also Experten mit themenspezifischen bzw. applikationsspezifischen (z.B. Online-Marketing oder eCommerce) und interface-ergonomischen Wissen. Dann ist gewährleistet, daß ein hoher Prozentsatz der Usability-Probleme aufgedeckt wird. Dies ist jedoch ein wichtiger praxeologischer Schwachpunkt, da diese Doppelexperten eine knappe und teure Ressource sind.

„Positiv und negativ zu gleich: großer Interpretationsspielraum“

Bei der Beschreibung der Usability-Probleme richten sich die Evaluatoren nach den Heuristiken. Sie sind für alle Evaluatoren gleich. Jedoch liefert deren Inhalt sehr viel Spielraum für Interpretationen, die jeder Evaluator aufgrund seiner persönlichen Meinung und seines Expertenwissens vornimmt. Dies ist sowohl Stärke als auch Schwäche dieser methodischen Vorgehensweise. Einerseits ermöglicht genau dieser Interpretationsspielraum ein breites Anwendungsfeld der Methode, sowie die Entwicklung von site- bzw. shopindividuellen Problemlisten auf deren Basis Handlungsempfehlungen zur Optimierung der Usability abgeleitet werden können. Andererseits bedeutet dieser Interpretationsspielraum, daß die Bewertungskriterien, auf die ein Evaluator seine Einschätzung der Probleme stützt, von Person zu Person variieren kann und nicht nachvollziehbar sind. Die Inter-Rater-Reliabilität und damit die Durchführungsobjektivität ist bei dieser Methode stark eingeschränkt.

3. Neuer Ansatz der expertenbasierten Usability-Evaluation: Heuristische Website-Usability-Checklist

Eine Kompensation der aufgezeigten Schwächen kann durch eine Teilstandardisierung der heuristischen Regeln erzielt werden. eResult hat deshalb auf Basis der Heuristiken eine Website-Usability-Checkliste entwickelt. Diese Checkliste umfaßt eine umfangreiche Sammlung von formalen Gestaltungsmerkmalen einer Website bzw. eShops. Diese Items wurden auf Basis der neuesten wissenschaftlichen Erkenntnissen der Usability-, Webdesign-, Hypertext- und HCI-Forschung (Human-Computer-Interaction) hergeleitet. Darüber hinaus wurde die Checkliste um eCommerce-spezifische Aspekte ergänzt. Beispielsweise um Aspekte der nutzungsfreundlichen Produktdarstellung, Gestaltung des Transaktionsbereichs, etc. Aktuelle Erkenntnisse der eCommerce- und Online-Marketing-Forschung wurden hier berücksichtigt.

Durch die Teilstandardisierung kann die Inter-Rater-Reliabilität gesteigert werden, gleichzeitig werden die Evaluatoren kognitiv entlastet. Die standardisierten Ergebnisse liefern ganz konkrete Ansatzpunkte für eine Verbesserung des Designs und der Usability. Die systematische Integration von qualitativ offenen Regeln gewährleistet, daß die Evaluatoren weiterhin auf die im Einzelfall gegebenen Restriktionen und Besonderheiten eingehen können. Deshalb wollen wir auch von einer heuristischen Checkliste sprechen. Heuristisch im Sinne von NIELSEN (1993), daß der Evaluator den Shop inspiziert und trotz der standardisierten Checkliste den Freiraum hat, eine eigene, ergänzende auf die speziellen Gegebenheiten des jeweiligen Shops zugeschnittene Problemliste zu erstellen.

4. Wann kann ich expertenbasierte Usability-Evaluation in meinem Internet-Projekt einsetzen?

Der Einsatz expertenbasierter Usability-Evaluation ist sinnvoll,

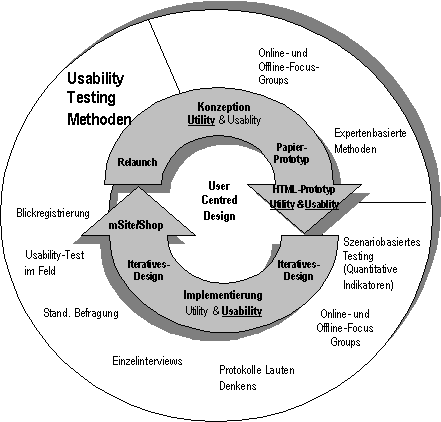

- wenn sich das Projekt in einem frühen Stadium befindet (siehe Abbildung 1 – Usability-Testing-Circle); beispielsweise wenn eine Auswahl zwischen verschiedenen Konzepten ansteht oder erst der statische HTML-Dummy fertig gestellt ist

- für eine laufende wiederholte Verbesserung der Usability im Design-Prozeß und Ergänzung zu nutzerbasierten Usability-Testings

- wenn sehr hoher Zeitdruck gegeben ist oder nur ein geringes Budget zur Verfügung steht, so daß ein nutzerbasiertes Usability-Testing nicht in Frage kommt.

Literatur DESURVIVRE, H.W. (1994). Faster, cheaper! Are Usability Inspection Methods as effective as empirical testing?, in: J. NIELSEN & R.L. MACK (Eds.). Usability Inspection Methods, New York: John Wiley, pp.173-202

JEFFRIES, R., MILLER, J.R., WHARTON, C. & UYEDA, K.M. (1991). User interface evaluation in the real world: A comparison of four techniques, in: Proceedings ACM CHI-´91 Conference (New Orleans), pp.119-124

KARAT, C., CAMPBELL, R.L. & FIEGEL, T. (1992). Comparison of empirical testing and walkthrough methods in unser interface evaluation, in: Proceedings ACM CHI-´92 (Montery), pp.397-404

NIELSEN, J. (1992). Finding usability problems through heuristic evaluation, in: Proceedings ACM CHI-´92 Conference (Monterey), pp.373-380

NIELSEN, J. (1993). Usability Engineering, San Diego: Academic Press

NIELSEN, J. (1994). Heuristic evaluation, in: J. NIELSEN & R.L. MACK (Eds.). Usability inspection methods, New York: John Wiley, pp.25-62